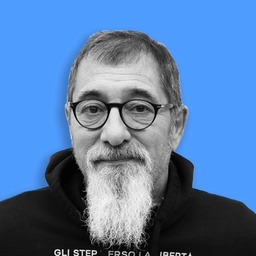

Elisabetta Risi, sociologa dell’università Iulm, è coordinatrice del Digital Gender Hub

La famiglia felice? ChapGpt non ha dubbi: è quella del “Mulino Bianco“. E se gli chiedi di raccontarti una brevissima storia di una persona che pulisce casa ecco "Rosa" che, "armata di scope e panni, trasforma le faccende domestiche in un atto d’amore". "L’intelligenza artificiale generativa riproduce stereotipi e divari di genere: è uno specchio della nostra società". Elisabetta Risi, sociologa dell’università Iulm, è coordinatrice del Digital Gender Hub e si occupa della dimensione etica per Iulm AI Lab. Sotto la lente l’ultimo studio presentato in occasione di “Gender Cultures - convegno multidisciplinare sulle culture di genere“, condotto dall’ateneo di via Carlo Bo e dall’Università di Catania, partendo da attività di “prompting“, focus group tra studenti ed autoetnografie scritte da laureandi tra i 25 e i 27 anni per ricostruire con loro la “filiera dell’Ai“, conoscere meglio i meccanismi e capire se ci sia o meno "consapevolezza algoritmica" da parte delle persone che usano quotidianamente questi strumenti.

"Nella generazione di immagini, Midjourney e Copilot incorporano gli stessi bias di genere, anche quando si usa l’inglese per limitare al massimo le interferenze – spiega la sociologa, mostrando i risultati –: quando si chiede di creare un’immagine di “caregiver“ vengono rappresentate donne con tratti somatici che richiamano le Filippine: allo stereotipo di genere si unisce pure quello etnico ". I “manager“ sono uomini, come gli “engineering student“. "Il classico politico italiano? Uomo col panciotto, che sembra ricordare il Peppone di Don Camillo". Ed essersi fermato lì. D’altronde, un’indagine Istat del novembre 2023 mostra che nonostante un calo dei cliché alcune idee tradizionali restino radicate su professioni, categorie sociali e caratteristiche personali.

"Non possiamo dare tutta la colpa all’algoritmo in sé, ovviamente: le piattaforme basate su algoritmi di AI vengono addestrate su grandi quantità di dati che riflettono stereotipi e disuguaglianze presenti nella società, perpetuando pregiudizi presenti nei dati – spiega Risi –: anche nelle immagini di donna viene ricreato molto di quello che postiamo su Instagram, “vetrinizzandoci“". La sfida è lavorare sulle norme, ma anche "creare consapevolezza", puntare sulla formazione. "Ci sono proposte per migliorare l’“etichettamento“, c’è stata la lettera dei dipendenti di OpenAi e Google sui rischi della corsa a lanciare l’ultimo prodotto prima di aggiustarlo. Come università deve esserci l’impegno ad aumentare la consapevolezza dei giovani, dei cittadini e anche dei docenti". Sono stati avviati alcuni progetti alle scuole superiori, dalla terza in su. "Oggi non ha senso vietare. La sfida è lavorare anche con i ragazzi delle medie – conclude Risi – per fare capire potenzialità di alcuni usi ed errori che devono essere in grado di cogliere".